Trouver, accéder, lire, traduire et comprendre la science

le 22 septembre 2018

La science est une discipline riche et passionnante qui est souvent mal comprise, généralement à cause de son traitement médiatique. J'ai beaucoup abordé ici le concept de neurofeedback, expliquant sa définition, son mode d'action et ses cibles thérapeutiques possibles. J'ai démystifié les solutions qui prétendaient en être, mais qui ne le sont pas. Je me suis permis beaucoup de critiques, en vous répétant sans cesse : ne faites pas confiance, demandez des preuves.

Et en toute honnêteté, niveau neurofeedback, je ne vous en ai apporté aucune. Il va être temps d'en apporter, ce sera l'objet d'un prochain article. Ce que je veux surtout vous expliciter ici, c'est comment vous allez pouvoir vérifier les preuves scientifiques que je vais apporter dans le futur. Ne pas faire confiance et se fier aux preuves : c'est être capable de remonter à la source d'un texte de vulgarisation, pour vérifier si le vulgarisateur ne vous raconte pas des conneries.

Pour cela, il faut partir avec quelques éléments bien en tête.

Dans mes articles, j'utilise le gras ou l'italique pour mettre en évidence les choses importantes. Les textes en indigo, sont des liens, vous redirigeant vers la source de mes affirmations. Pensez à cliquer dessus si vous voulez plus d'informations. L'article vise à vous donner les bases ; les liens associés, à aller plus loin.

Un "livre" n'est pas une preuve scientifique. Dans une librairie, vous pouvez trouver des livres (sans blague) écris en français, par des "spécialistes" ou "experts". Ils sont soit auto-proclamés, soit à force de les voir à la TV, on fini par penser qu'ils ont une expertise. Un livre vendu au grand public, dans son essence même, ne peut être que de la vulgarisation scientifique qui peut donc être, soit bien faite, soit -et c'est souvent la règle- mal faite et ne viser qu'à faire l'auto-promotion de son auteur qui bien souvent a quelque chose à vous vendre. Le cas typique, c'est tous ces "coach" qui écrivent des livres pour appuyer leur opinion plutôt que de vous apporter des preuves.... et quand on relève un discours faux, ces gens ne répondent pas avec des études scientifiques..... mais avec des livres grands publics qui vont dans leur sens. C'est donc un cercle fermé sur lui-même qui ne repose sur aucune preuve. On a aussi le cas d'anciens scientifiques enrôlés par les médias, qui n'ont rien produit scientifiquement depuis des décennies, mais continuent d'écrire des bouquins sur leur théorie de l'époque.... et bien souvent, la science a évolué depuis, alors que leur discours.... non.

Alors, si vous lisez un livre, regardez si l'auteur cite des sources scientifiques. J'ai une pelleté de bouquin sur le NeurOptimal (dont les gens pratiquant cette technique m'ont filé les références pour certifier que la technique fonctionnait).... mais c'est 200 pages de témoignages, d'anecdotes de praticien.... avec 0 source scientifique. Ce n'est donc pas une preuve. Même si il y a 200 pages.

Il existe de vrais livres scientifiques (comme ceux de l'AAPB) mais c'est en anglais. Sinon, vous avez les revues, j'en parle au point 6. Là, c'est réellement de la science qui prend de la hauteur.

Un témoignage n'est pas une preuve

En science clinique, les chercheurs sont soumis à d'autres contraintes que celles des chercheurs de laboratoire. Dans mes recherches passées (effectuées sur la souris), je ne pouvais pas me baser sur des témoignages, je n'avais donc aucun problème. Sérieusement, vous avez déjà vu une souris parler, vous ? Notre travail est donc de créer des protocoles expérimentaux qui vont poser une -et une seule- question à notre souris.

En revanche, en clinique, vous pouvez demander à quelqu'un : es-tu anxieux ? La personne répondra "oui" ou "non" ou "peut-être", mais cela dépendra de sa perception d'elle-même et ne peut en aucun cas être un bon marqueur d'anxiété. A vrai dire, la majorité d'entre-vous ignore la définition scientifique de l'anxiété. Alors, vous demander si vous êtes anxieux, c'est déjà biaisé. On pourrait alors envisager un questionnaire, avec des questions ciblées. C'est très commun en science clinique, mais ce n'est pas encore parfait, car il s'agit d'un témoignage. On pourrait par exemple vouloir associer cela avec une prise de sang, pour voir si certains marqueurs (sérotonine, cortisol, catécholamine,...) sont présents à des taux anormaux.

On passe ici du témoignage qui est invérifiable à des données biologiques mesurables, comparables et analysables statistiquement. La science, c'est cela : se casser la tête pour trouver des mesures répétables, quantifiables et comparables entre les individus.

Dans les questionnaires, tout n'est pas bon à jeter, évidemment. Mais seuls, ils ne suffisent pas. C'est pourquoi, quand une étude clinique se base uniquement sur des questionnaires, je reste prudent. Dans le cadre du Neurofeedback, associer l'entretien clinique à une analyse en EEGq (électroencéphalogramme quantitatif) permet d'ajouter au témoignage du patient une mesure de son activité cérébrale qui est alors comparée à d'autres, via des bases de données.

Faites attention aux médias généralistes qui parlent de science

La science, c'est précis, carrée et soyons honnêtes, ça ne fait pas rêver (pas de licornes ou de pouvoirs mystiques chez nous). Du coup, quand les médias traitent de science, c'est très simplifié, généralisé, extrapolé et souvent, cela en devient faux (comme les pluies de diamants sur Neptune, hein).

Si un témoignage n'est pas une preuve : une étude scientifique n'en est pas une non plus. Enfin, pas immédiatement après sa publication. Donc déjà, un article grand public qui parle "d'une étude sortie aujourd'hui a démontré que", ben, en fait, non. L'étude a peut-être des résultats géniaux, ils sont même peut-être tout à fait corrects : mais seule la réplication par d'autres équipes fera que la première est validée(*). Quand j'ai publié mon article en 2015 sur ma souris, il a fallu presque 2 ans -que d'autres études valident mes expérimentations- pour me dire "ouf, je n'ai pas raconté de bêtises". Même en toute bonne foi, il peut y avoir des biais que le chercheur n'a pas remarqué et qui pourraient rendre l'étude complètement fausse. C'est désagréable, ça arrive. C'est pourquoi, une seule étude n'est pas une preuve tant qu'elle n'a pas été répliquée pas d'autres.

(*) En vrai, republier un résultat existant est quasi-impossible en science, ce n'est pas vendeur. Ce qui a pu faire l'objet d'une publication entière, servira par la suite de petite expérience contrôle en début d'un autre papier. Ou, il y aura une petite phrase discrète disant "nous avons refait l'expérience de .... et sommes d'accords avec eux". Voir parfois, la personne qui reprend le projet dans le laboratoire (la précarité en science, toussa), refera quelques manips de son prédécesseur pour être bien certain du résultat. C'est plus souvent quand un résultat n'arrive pas à être répliqué que les autres chercheurs vont pouvoir faire une publication dessus. Et prouver que l'on a faux, c'est la science. En aucun cas, on ne prouve que quelque chose est vrai.

C'est ici que l'on parle des méta-analyses. La méta-analyse compile plusieurs études sur le même sujet, afin d'en tirer un résultat encore plus solide(*). Par exemple, dans mon domaine, c'est la méta-analyse de Cotton et ses collègues qui a permis de clarifier une bonne fois pour toute si les patients atteints de myopathie de Duchenne avaient une altération de leur quotient intellectuel (QI). En gros, pour m'auto-citer, cela donne dans un contexte scientifique :

Dans leur méta-analyse (1 146 patients issus de 32 études réalisées entre 1960 et 1999), Cotton et al. (2001) estiment le QI moyen des patients à 80,2 (significativement différent de 100) avec un minimum à 14 et un maximum à 134. 34,8% ont un QI inférieur à 70, et 28% ont un QI inférieur à 50. Il tranchera également sur un vieux débat : les patients ont-ils un QI verbal plus faible que le QI performance ? Cotton apportera cette réponse : le QI verbal est effectivement 5 points plus faible que le QI performance, mais au vu de sa méta-analyse, cette différence n’est pas cliniquement significative.

(*) Dans ce cas précis, le test de QI est une expérience parmi plus d'une dizaine que va comporter chaque étude. Ce n'est que rarement le sujet principal des études qu'a compilé Cotton. L'intérêt des méta-analyses, c'est de sélectionner un paramètre (ici, le QI) et de l'extraire de nombreuses études, qui traitent à la base, d'un autre sujet.

La méta-analyse prend donc des articles de 1960 à 1999 : imaginez si les médias devaient attendre 39 ans pour parler de science ! Non, ils en parlent tout de suite (souvent avant que le reste de la communauté scientifique y ait accès, en fait...) pour faire jouer l'effet d'annonce, au risque de raconter des conneries. C'est comme ça qu'on a vu arriver des idées fausses qui ont maintenant la peau dure : mouvement anti-vaccin, mémoire de l'eau pour expliquer l'homéopathie, ou le fait que les OGMs seraient toxiques....

Les médias, ils sont là pour faire du cl(fr)ic, donc si vous recherchez de l'information (de qualité), surtout en science, évitez-les. (Exemple contradictoire : cet article de Le Monde sur l'homéopathie, dopé aux méta-analyses)

Un exercice auquel je m'adonne régulièrement devant les journaux télévisés est : combien d'information il y a-t-il dans un reportage ?

Un témoignage n'est pas une information, un ressenti d'une personne n'est pas une information, un micro-trottoir n'est pas une information, un avis d'expert n'est pas une information. Une étude scientifique est un début d'information. Une méta-analyse est une information. Vous vous rendrez vite compte que sur 30 ou 40min du journal, vous allez apprendre 1 ou 2 informations noyées dans une centaine d'autres trucs qui ne sont là que pour meubler et flatter vos émotions.... (plus d'informations dans cette vidéo de Horizon Gull).

Où trouver des articles scientifiques ?

En Science, ma base de donnée préférée, c'est Pubmed. Vous tapez quelques mots-clefs et il va vous sortir une liste d'articles qui traitent de la question.

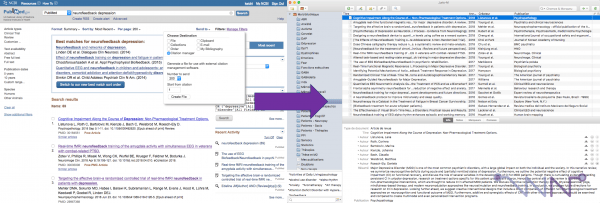

Dans le cadre du neurofeedback, PubMed recense 1 371 articles. On voit à droite que le nombre d'article traitant de ce sujet augmente au cours des années. Cela ne signifie pas nécessairement que les scientifiques s'y intéressent plus, mais surtout que de plus en plus d'articles sont publiés chaque année, en gros, dans tous les domaines. On peut aussi voir sur la gauche, la possibilité de trier par type (essai clinique, revue de la littérature,...), en fonction de l'espèce (humain, rat, souris,...) ou en fonction de la date.

La page d'un article suit toujours le même modèle :

- en haut, le nom de la revue où l'article est publié et l'année ;

- en dessous, le titre et la liste des auteurs. Généralement, le premier est l'expérimentateur principal et le dernier, son chef (qui a établi le protocole / trouvé les financements) ;

- puis un résumé (abstract) de l'article ;

- et dans la colonne de droite, vous trouverez soit un lien vers l'article complet sur le site de l'éditeur (ici Frontiers) -qui peut être payant- et parfois d'autres boutons, comme ici, un lien vers l'article complet, directement dans Pubmed.

En France et en science, il faut bien comprendre que :

- le chercheur est payé par un organisme (entreprise ou état français) ;

- le chercheur se débrouille pour trouver des financements pour ses recherches (appareils, animaux de laboratoire,...) et payer les salaires de ses étudiants (doctorants, master,....) ;

- le chercheur paie un éditeur pour que son article soit publié dans sa revue (après critiques des pairs, il faut de qualité scientifique, hein... -les pairs, c'est des scientifiques qui font cela bénévolement sur demande des éditeurs-) ;

- le chercheur peut -ou non- payer pour que son article soit disponible gratuitement ;

- le chercheur paie (ou l'Université, ou l'Entreprise) pour avoir accès aux articles scientifiques.

Le cas extrême, c'est par exemple :

- le chercheur est un fonctionnaire, donc payé avec vos impôts ;

- le chercheur peut avoir des financements par des associations comme le Téléthon, donc paie son matériel / étudiants avec vos dons ;

- le chercheur va payer un éditeur avec vos dons, pour voir son travail -que vous avez financé- publié ;

- l'Université va payer l'éditeur (donc, avec vos impôts) pour que les autres chercheurs aient accès à la revue où l'article a été publié ;

- ... et vous, si vous voulez l'article, il faut payer directement l'éditeur.

Un chouette monde, ce monde de la recherche scientifique, pour le bien commun et le libre échange de la connaissance.

C'est un business que nous sommes de plus en plus nombreux à dénoncer. En mars 2018, mon Université (Paris-Sud XI) envoyait un message à tout le monde pour dire que les frais d'accès à certaines revues étaient trop élevés donc que nous allions en perdre l'accès. C'est quand même triste quand on pense que l'éditeur ne fait que de la mise en page et vend son accès plusieurs millions chaque année.....

Comment accéder aux articles scientifiques ?

Si l'article est en libre consultation, nous avons déjà parlé du lien dans Pubmed pour y accéder.

Si en revanche, il est payant, quatre solutions :

- contacter directement le chercheur pour lui demander une copie de l'article. Un chercheur ne devrait normalement jamais refuser cela. Depuis quelques années, on a même un réseau social (ResearchGate) spécialisé où on s'échange les articles entre nous (on fait d'autres trucs aussi, dessus) ;

- utiliser l'accès de votre Université à la revue, ce qui nécessite, une université et un laboratoire d'attachement pour avoir les codes ;

- demander gentiment sur Twitter, avec le hashtag #ICanHazPDF ;

- ou alors, et c'est complètement illégal, passer par le site internet Sci-Hub.tw (Twitter : @Sci_Hub).

Si nous connaissons tous plus ou moins les plateformes de téléchargement illégal, Sci-Hub est son pendant pour les articles scientifiques. Pour en savoir plus, vous pouvez consulter la page Wikipédia qui est très bien faite. Pour l'anecdote, de nombreux universitaires passent par Sci-Hub, plutôt que par les accès de leur laboratoire car c'est... plus simple d'utilisation. Tout n'est pas disponible, mais Sci-Hub peut rendre de grands services.

D'autres plateformes existent (dont certaines citées sur la page Wikipedia de Sci-Hub), mais Sci-Hub reste la majoritaire (on estime à 95% de la littérature scientifique disponible dessus). C'est illégal, donc je ne peux pas vous conseiller de l'utiliser. Après, je ne peux pas vous l'interdire non plus, hein....

Au delà de Sci-Hub, d'autres affaires ont émaillées le monde la littérature scientifique. Si le sujet vous intéresse, un documentaire nommé "The Internet's Own Boy: The Story of Aaron Swartz" est disponible gratuitement sur Amara, une plateforme de sous titrage collaboratif. Si vous ne connaissez pas Aaron Swartz, le voici en quelques mots :

- à 12 ans (en 1998), il créé un précurseur de Wikipédia ;

- à 14 ans, il participe à la création du standard RSS, encore largement utilisé ;

- à 15 ans, il contribue à la création de la licence Creative Commons, alternative du Copyright, largement utilisé de nos jours ;

- à 19 ans, il contribue à la création du site internet Reddit (le huitième site le plus visité au monde) ;

- il est aussi contributeur de la norme W3C (pour la création de site internet) et élabore avec J. Gruber le langage Markdown aujourd'hui utilisé par la majorité des journalistes ;

- et pleins d'autres choses sur les quelques années qui lui reste à vivre...

Le 11 janvier 2013, Aaron Swartz (26 ans) s’est pendu dans son appartement de Brooklyn. Son procès fédéral en lien avec les accusations de fraude électronique devait débuter le mois suivant. En cas de condamnation, il encourait une peine d'emprisonnement pouvant atteindre 35 ans et une amende s'élevant jusqu'à 1 million de dollars.

Cette "fraude électronique" étant uniquement un petit script permettant de télécharger tous les articles scientifiques de l'éditeur JSTOR (en passant par l'accès légal de son université, hein, mais les scripts automatiques, c'était très nouveau à cette époque)...

C'est pour ça, qu'aujourd'hui, je milite un peu pour la libre circulation des articles scientifiques....

Traduire les articles scientifiques

Une fois l'article en main, le plus difficile est de le lire.

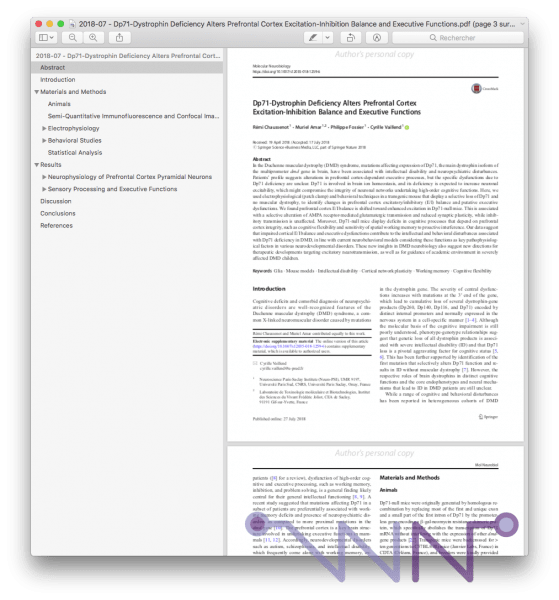

Dans la philosophie, tous les articles sont construits de la même façon :

- un résumé (abstract, toujours en libre accès) qui permet de voir de quoi l'article parle et quelles sont les conclusions ;

- une introduction pour situer le contexte de l'étude et pourquoi elle est intéressante ;

- le matériel et méthodes utilisés pour que d'autres chercheurs puissent répliquer l'étude ;

- une partie résultats avec des graphiques et statistiques des trouvailles des chercheurs ;

- une partie discussion qui interprète les résultats et les confrontent aux autres études ;

- une partie conclusion qui met en perspective les résultats et éventuellement, ce qu'il reste à faire ;

- une partie "conflits d'intérêt" (juré!) ;

- et la bibliographie des études citées dans l'article pour que le lecteur puisse les lire pour en savoir plus.

Pour un non-chercheur, lire l'introduction, la discussion et la conclusion est, en général, suffisant. L'introduction va vous apporter un peu de culture sur le sujet, la discussion vous expliquer les résultats de l'étude et la conclusion va vous permettre de voir ce que pense les chercheurs de leur étude, vu que c'est en général là, où on colle un "attention, c'est des résultats à vérifier" ou "il faudrait aussi faire ça et ça pour être bien certain" (qu'en général, les médias ignorent complètement..... HEIN .....).

Si vous ne parlez pas anglais, je vous conseille fortement DeepL.com, qui est un traducteur automatique nourri à l'intelligence artificielle. Il n'est pas parfait, mais franchement, il fait plutôt bien le job. Rien ne vous empêche, par la suite, d'utiliser Wordreference ou Linguee pour affiner la traduction. D'ailleurs, Linguee est à la base de DeepL et c'est ce qui fait de ce traducteur le meilleur à l'heure actuelle.

A titre personnel, j'utilise DeepL pour traduire les articles de ce blog en anglais. Ce n'est pas nécessairement un anglais de qualité en sortie, mais c'est compréhensible et le message qui doit passer, passe. Bon, je passe quand même quelques heures à le corriger sur les plus grosses boulettes, mais ça fonctionne plutôt bien, à partir du moment où le texte source est correctement écrit (orthographe et syntaxe). Je sais que des amis l'utilisent pour faire un premier jet de traduction, car c'est souvent plus simple de retravailler un texte que de l'écrire à partir d'une page blanche.

Commencer en science : les revues

J'en parlais plus haut, PubMed vous offre la possibilité de trier par type de document et un des filtres permet de n'afficher que les revues.

Une revue est écrite par un chercheur, dans l'optique de faire le point sur l'état des connaissances sur un sujet précis. Elles sont de qualités diverses, pour ces raisons :

- certains chercheurs écrivent des revues pour augmenter leur nombre de publication (qui font office de CV, comme dit ici) et ne font que du copier/coller des résumés d'articles (on s'en aperçoit quand on va voir les articles cités) ;

- certains chercheurs écrivent des revues pour ne citer que leurs travaux (ce qui augmente leur h-index, une mesure de la qualité supposée d'un chercheur, ça se repère à la bibliographie de fin) ;

- certains chercheurs écrivent des revues pour influencer la communauté scientifique et médiatique (et font de fait du cherry picking).

Mais nous avons aussi des chercheurs qui font très bien leur travail, synthétisant avec brio plusieurs centaines d'articles dans un document d'une dizaine de pages, qui permet de commencer à aborder un sujet avec une vue plus clair du paysage actuel. C'est aussi le bon endroit pour apporter son opinion ou établir des hypothèses. Écrire une bonne revue, c'est la possibilité d'être publié dans un très bon journal et peut être, le point d'orgue d'une carrière scientifique (et or mis du temps et un ordinateur, c'est peu coûteux à produire).

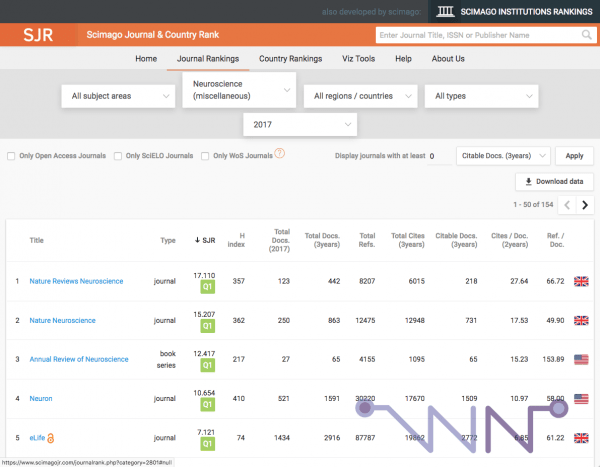

Donc certes, il faut garder un esprit critique, vous pouvez d'ailleurs regarder le facteur d'impact du journal dans lequel la revue est publiée, afin de voir si ce journal est réputé ou non. C'est en regardant ce genre de table, que je me suis permis de dire que les seules études à propos du NeurOptimal, publiées dans des journaux à des facteurs d'impacts inférieurs à 1, étaient probablement mauvaises. Pour chaque discipline, les valeurs changent, donc impossible de donner une consigne générale pour toutes les disciplines.

Et en cas de soucis, la Station des Sciences sur Facebook sera heureuse de vous aider dans votre recherche d'une information de qualité ! :-)

Bonus : les gestionnaires de bibliographie

Les gestionnaires de bibliographie sont très pratiques pour générer à la volée la bibliographie des articles que l'ont écrit en science. Tous les chercheurs n'en utilisent pas, certains vont tout stocker dans des dossiers et le faire manuellement. Mais, c'est quand même pratique, d'autant plus que PubMed offre la possibilité d'importer tous les articles d'une recherche, directement dans le gestionnaire.

A titre personnel, j'utilise Juris-M qui est une version dérivée de Zotero. D'autres existent (voir cette page Wikipedia) et en font parfois beaucoup plus que mon Juris-M qui est très austère et peu pratique. Mais je ne suis pas un très grand fan de ces logiciels et c'était le seul qui s’interfaçait avec Scrivener, mon logiciel de gestion de projet d'écriture que j'aime d'amour tant il m'a aidé à rédiger ma thèse (il est payant, mais en aurez pour votre argent -non je ne suis pas sponsorisé par Scrivener-).

Pour le prochain article, j'ai donc récupéré dans Juris-M tous les articles qui traitent d'un sujet précis depuis Pubmed. Ayant accès au résumé directement dans Juris-M, je vais pouvoir faire un premier tri, pour voir les plus intéressants. Ensuite, avec un double clic, je peux aller voir l'article sur le site de l'éditeur (s'il n'est pas payant), ou donner l'adresse de cette page à Sci-Hub pour... vous savez quoi, maintenant.

Conclusion

Au terme de ce billet, vous devriez donc être en capacité d'aller chercher un article scientifique sur Pubmed, de comprendre sa structure et éventuellement de le traduire si nécessaire.

On parle de mon article sur le groupe Zététique, où vous trouverez des éléments supplémentaires dans les commentaires.

Donc quand vous êtes sur un article de vulgarisation, si vous avez des doutes sur la véracité de l'information, cherchez le lien vers la publication scientifique originale et allez la lire (généralement un petit lien "Source" tout en bas). Bien souvent, vous verrez qu'entre ce que le journaliste vous raconte et ce que les chercheurs ont écris dans leur publication, il y a tout un monde....

Concernant la pluie de diamants de LCI : le journaliste ne prend même pas la peine de donner un lien vers l'étude scientifique (que j'ai retrouvé grâce à un moteur de recherche) et vu l'explication de la publication faites par Astronogeek, LCI pour les informations scientifiques : c'est à fuir. A vous maintenant de repérer les journalistes qui citent leurs sources et qui font de la vulgarisation en accord avec la publication originale, ça va vous faire un sacré tri dans vos lectures...

Pour aller plus loin, je vous recommande ces chaines Youtube pour affûter votre esprit critique :

Vous avez aimé cet article ? Alors soutenez le blog et partagez-le avec vos amis en cliquant sur les boutons* ci-dessous :

Adresse de l'article :

http://chaussenot.net/trouver-acceder-lire-traduire-et-comprendre-la-science

* Ces boutons de partage sont respectueux de votre vie privée et évitent le tracking par les réseaux sociaux.